In un’epoca in cui l’intelligenza artificiale sta rivoluzionando il mondo del lavoro, il ruolo dei junior developer si sta trasformando. AWS CEO Matt Garman ha espresso la sua visione su come l’AI possa integrarsi con le competenze umane, piuttosto che sostituirle.

L’AI e la sua applicazione nel programming

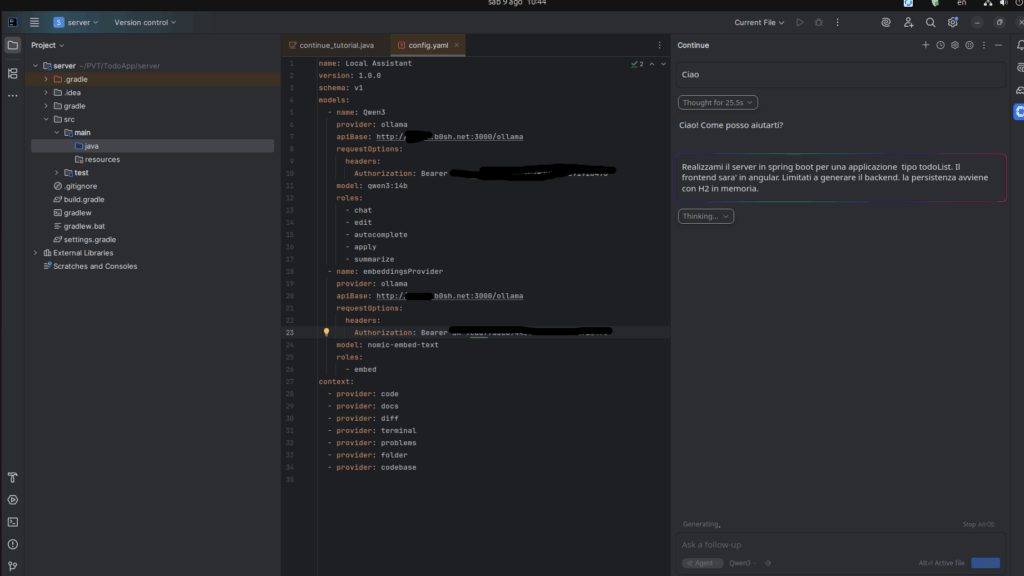

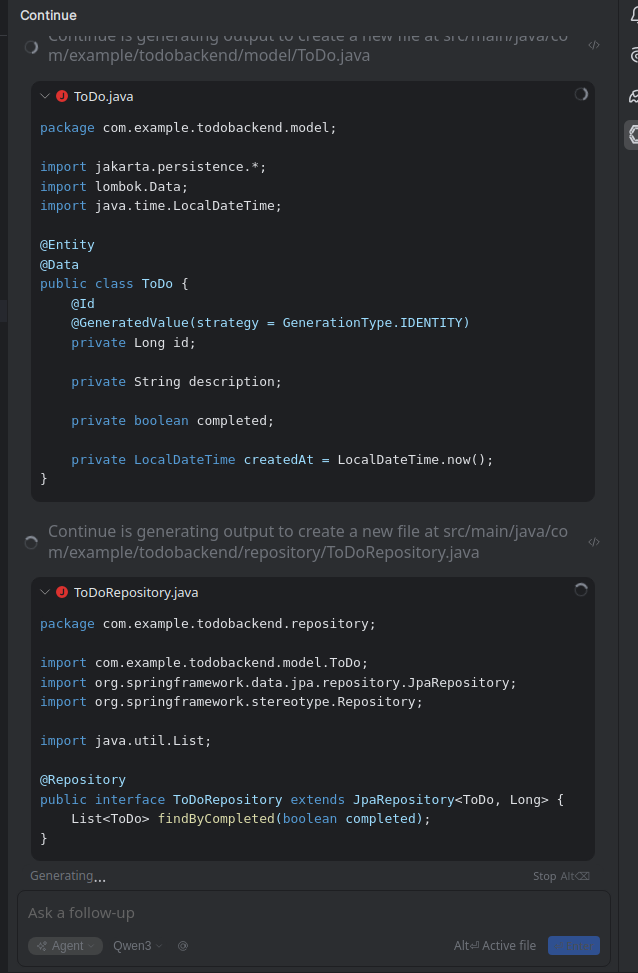

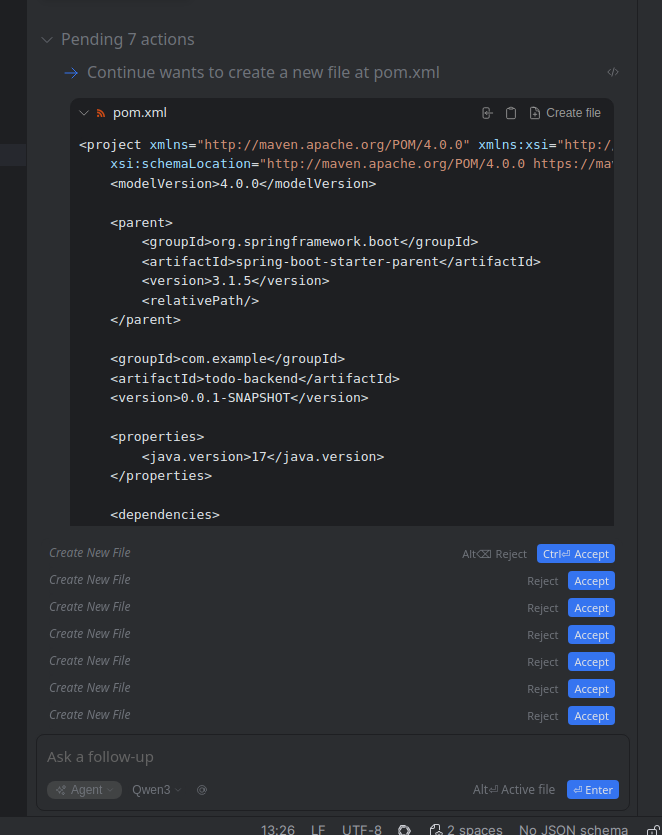

Nonostante l’AI possa semplificare alcune attività ripetitive, come la generazione di codice o l’ottimizzazione del debugging, non rappresenta una minaccia per i programmatori inesperti. Al contrario, offre loro strumenti potenti per imparare più velocemente e sviluppare competenze avanzate. I junior developer possono sfruttare l’AI per automatizzare compiti che richiederebbero tempo e pazienza, concentrando quindi le loro energie su aspetti più creativi e strategici del coding.

Con l’AI a disposizione, i junior developer possono ricevere feedback immediati durante lo sviluppo del software, migliorare la loro capacità di risolvere problemi complessi e affinare le loro abilità di pensiero critico. Questo non solo accelera il loro apprendimento, ma li prepara a svolgere ruoli più avanzati in futuro. Inoltre, l’AI può fungere da strumento di supporto per i junior developer, guidandoli attraverso processi di sviluppo complessi e aiutandoli a comprendere meglio i concetti di programmazione.

L’evoluzione del ruolo del junior developer nel contesto dell’AI richiede una visione proattiva: imparare a utilizzare queste tecnologie non come sostituti, ma come alleati. Questo approccio non solo rafforza il loro valore nel mercato del lavoro, ma li posiziona come attori chiave nell’innovazione tecnologica futura.

Il ruolo dei junior developer nel futuro del lavoro

Il ruolo dei junior developer nel futuro del lavoro è un tema cruciale in un contesto in cui l’intelligenza artificiale sta trasformando il mondo del programming. Matt Garman ha sottolineato che i junior developer non devono essere visti come una risorsa da sostituire con l’AI, ma come una opportunità di investimento per le aziende. I junior developer, infatti, sono i meno costosi e i più adattabili alle nuove tecnologie, rendendoli un elemento chiave per il successo delle organizzazioni.

Il loro ruolo non è solo di apprendere le competenze tecniche, ma anche di sviluppare abilità come il pensiero critico, la creatività e la capacità di risolvere problemi complessi. Queste competenze saranno sempre più importanti in un mondo in cui l’AI diventa un alleato, non un sostituto. I junior developer possono sfruttare gli strumenti AI per migliorare la loro efficienza e la loro produttività, senza perdere la capacità di pensare in modo autonomo e innovativo.

L’AI non eliminerà il ruolo dei junior developer, ma lo trasformerà. I programmatori del futuro non saranno semplici codificatori, ma problem-solver e gestori di agenti AI. Questo richiederà una continua formazione e un’adattabilità ai nuovi strumenti e alle nuove tecnologie. I junior developer dovranno imparare a utilizzare l’AI come un supporto per il loro lavoro, piuttosto che come una sostituzione.

Il futuro del lavoro per i junior developer è quindi un’opportunità, non una minaccia. Con l’adeguata formazione e l’uso intelligente dell’AI, i junior developer potranno diventare sviluppatori più efficienti, creativi e adatti alle esigenze del mercato del lavoro in evoluzione.

L’evoluzione del ruolo del developer

In questo capitolo, affronteremo l’evoluzione del ruolo del developer in un mondo dominato dall’AI. Matt Garman ha sottolineato che i programmatori non saranno sostituiti, ma il loro lavoro si trasformerà. Questo capitolo analizzerà come i developer passeranno da semplici codificatori a problem-solver e gestori di agenti AI. Verranno esaminate le nuove competenze necessarie per i developer del futuro, tra cui la capacità di prendere decisioni critiche, risolvere problemi complessi e gestire strumenti AI avanzati.

Garman ha sottolineato che il ruolo del developer non si limiterà a scrivere codice, ma si estenderà a comprendere e gestire le soluzioni AI. Questo richiederà una forte capacità di adattamento e una visione strategica per identificare quando e come l’AI può essere utilizzata per migliorare la produttività. I developer del futuro dovranno anche imparare a lavorare in sinergia con gli strumenti AI, interpretando i risultati e correggendo eventuali errori.

Inoltre, Garman ha sottolineato che l’AI non eliminerà il lavoro, ma lo trasformerà. I developer dovranno evolvere le loro competenze per rimanere rilevanti nel mercato del lavoro. Questo richiederà un impegno costante nell’apprendimento continuo e nell’adattamento a nuove tecnologie. Il ruolo del developer si trasformerà in un ruolo più creativo e strategico, dove il pensiero critico e la capacità di decisione saranno fondamentali.

Questo capitolo conclude che l’AI non eliminerà il ruolo del developer, ma lo trasformerà in una figura più versatile e strategica. I developer del futuro saranno chiamati a sfruttare l’AI come strumento di supporto, non come sostituzione, per raggiungere obiettivi più complessi e innovativi. Questo richiederà una combinazione di competenze tecniche, creative e strategiche, che renderanno i developer sempre più indispensabili nel mondo del lavoro.

L’importanza delle competenze umane nell’era dell’AI

L’evoluzione del ruolo del developer non è l’unica trasformazione in atto nell’era dell’intelligenza artificiale. I junior developer, in particolare, stanno assumendo un ruolo sempre più centrale nel mondo del lavoro tecnologico. Nonostante l’AI possa semplificare molte attività di programmazione, come la scrittura di codice ripetitivo, è chiaro che le competenze umane restano irrinunciabili. I junior developer, pur essendo alle prime armi, rappresentano una risorsa preziosa grazie alla loro capacità di apprendimento rapido e alla loro adattabilità ai nuovi strumenti e tecnologie.

Garman ha sottolineato che i junior developer non sono solo il futuro della programmazione, ma anche un’opportunità per le aziende di investire in talenti emergenti. Questi giovani professionisti possono imparare a lavorare in sinergia con l’AI, utilizzandola come strumento di supporto per migliorare la produttività e la qualità del lavoro. Inoltre, le capacità umane, come la creatività, la capacità di risolvere problemi complessi e il pensiero critico, sono fondamentali per guidare l’AI e massimizzare il suo potenziale.

I junior developer, quindi, non devono temere di essere sostituiti dall’AI, ma anzi, devono imparare a integrarla nel loro lavoro. Questo richiede una formazione continua e l’acquisizione di nuove competenze, come la gestione di strumenti AI avanzati e la capacità di prendere decisioni etiche e creative. Solo chi si adatta a questa nuova realtà potrà prosperare nel mercato del lavoro del futuro.

Conclusioni

L’AI non eliminerà i lavori, ma li trasformerà. I junior developer hanno un ruolo cruciale nel futuro del programming, e l’adattamento a nuove tecnologie sarà la chiave per successo e crescita professionale.

Questo post e’ realizzato tramite intelligenza artificiale basandosi su questo articolo: AWS CEO Says Replacing Junior Developers with AI Is the Dumbest Thing He’s Ever Heard